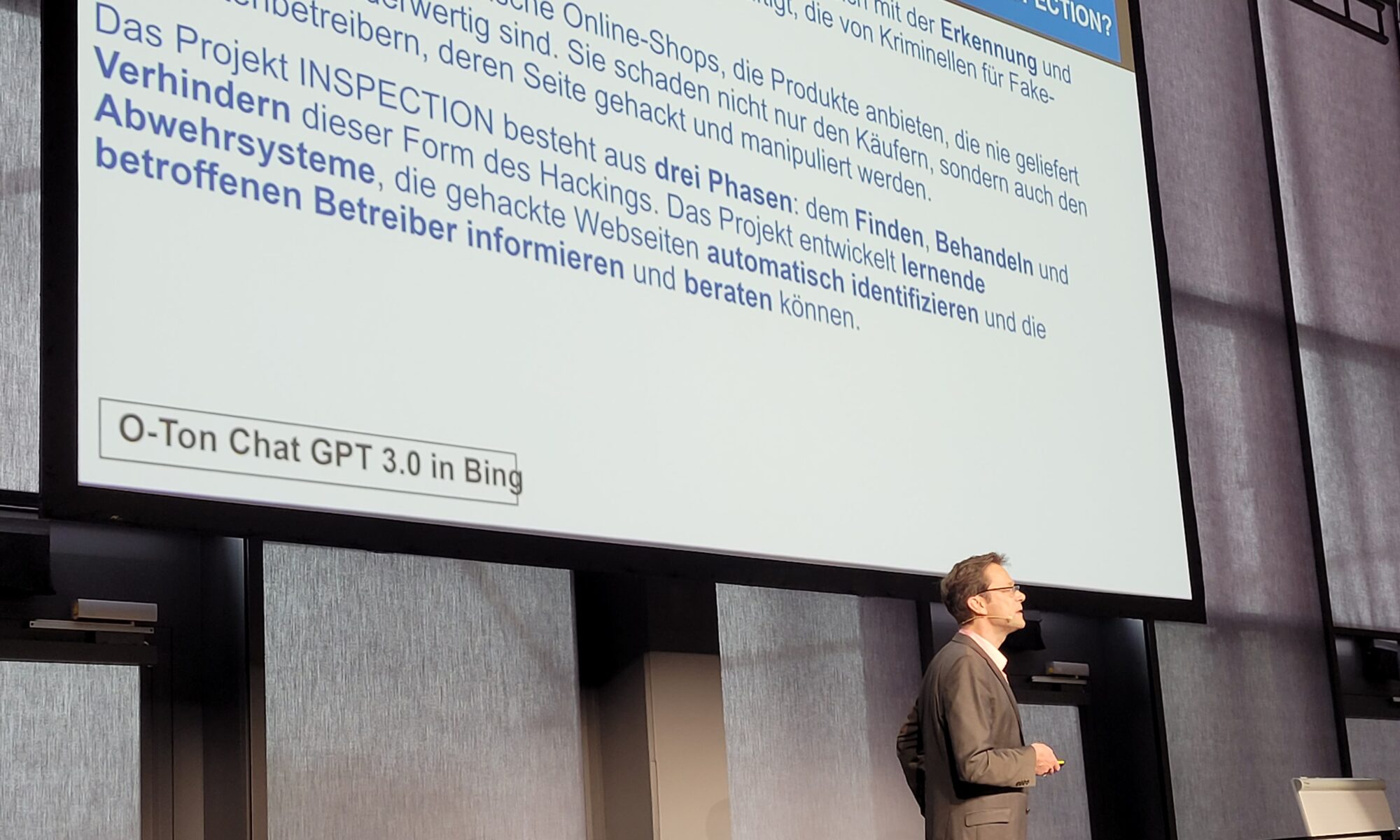

zum Forschungsprojekt INSPECTION zur Identifizierung gehackter Webseiten

Anne Hennig ist wissenschaftliche Mitarbeiterin beim Karlsruher Institut für Technologie (KIT) und betreut das Forschungsprojekt INSPECTION seitens des KIT. Bei den diesjährigen Internet Security Days (ISD) am 21. und 22. September wird sie einen Vortrag über das Projekt halten. Gemeinsam mit ihrem Kollegen Dr. Peter Mayer erklärt sie im eco Interview, was INSEPCTION ist und warum es eine wirkungsvolle Ergänzung zu bereits bestehenden IT-Sicherheitsansätzen sein kann.

Sie wirken bei dem Forschungsprojekt INSPECTION mit. Können Sie uns erklären, was Sie bei dem Projekt untersuchen und auf welchen Bereich der Cybersicherheit Sie sich konzentrieren?

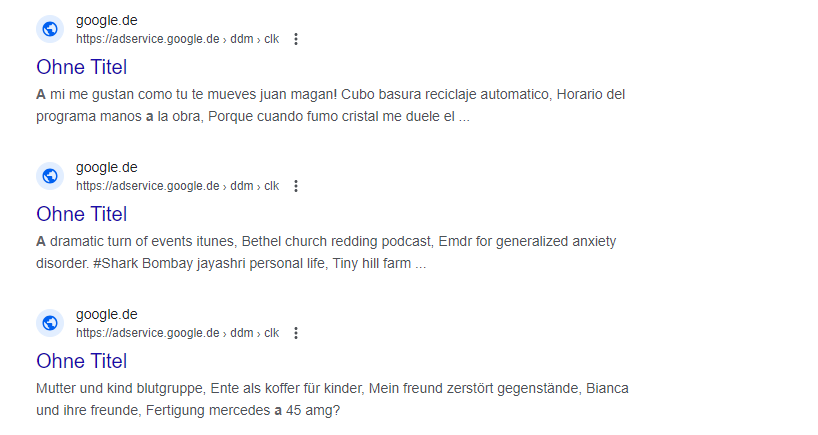

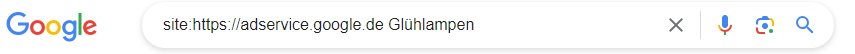

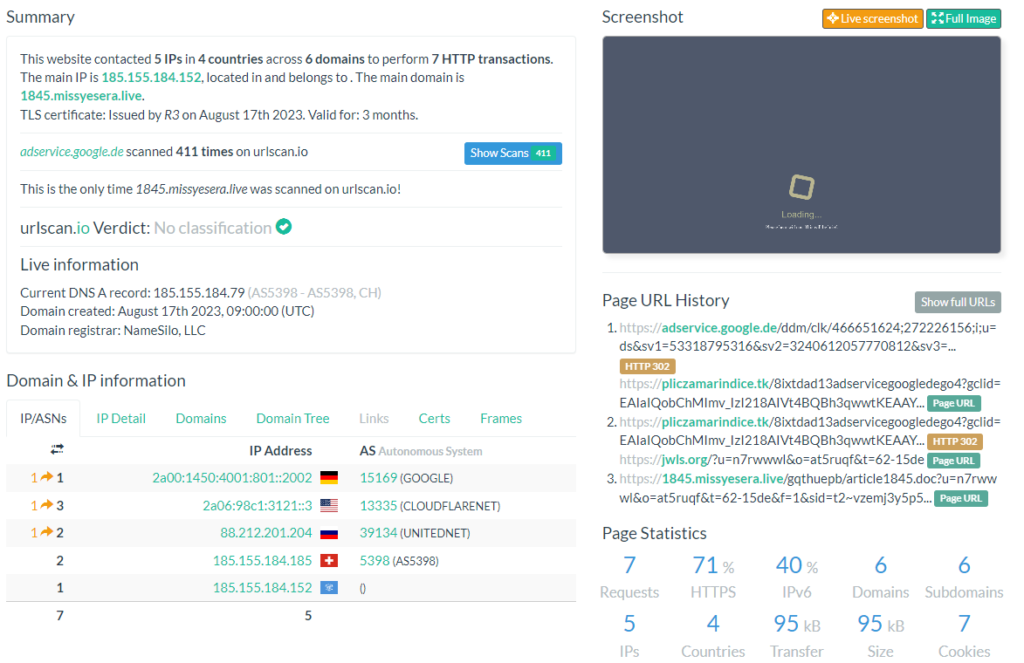

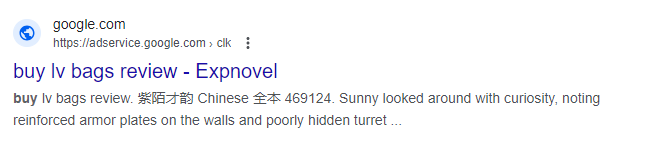

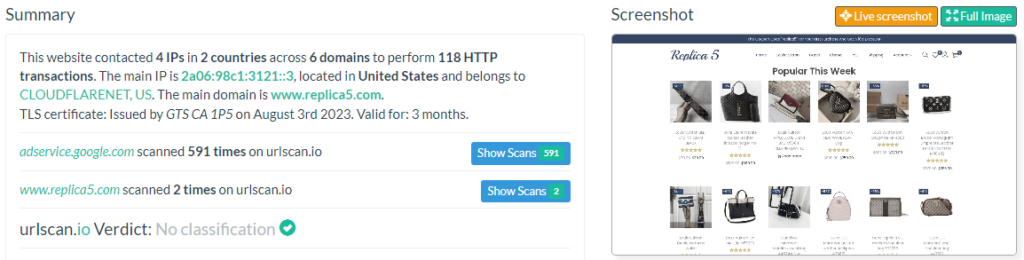

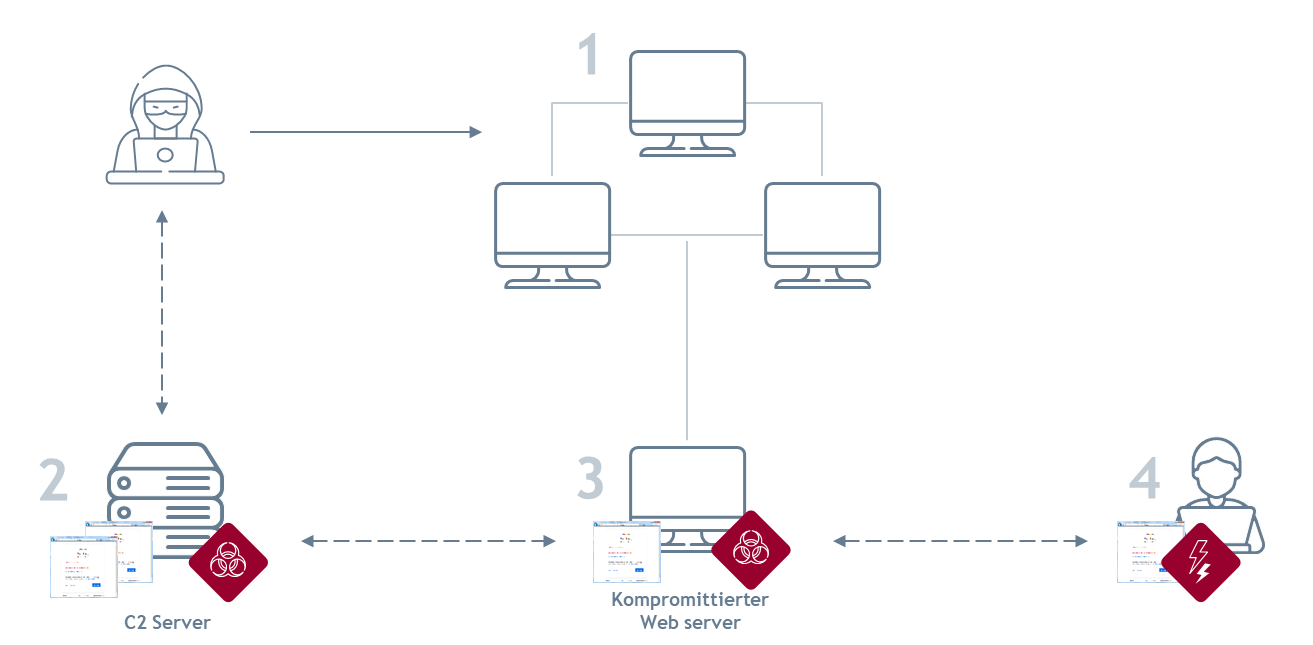

Im Forschungsprojekt INSPECTION arbeiten drei Konsortialpartner daran, eine bestimmte Art des SEO-Spam in Form von Weiterleitungen auf Fake Shops näher zu untersuchen. D.h., im wesentlichen beschäftigt sich das INSPECTION Projekt mit Web-Sicherheit, wobei wir uns hier konkret eine bestimmte Angriffsart auf Websites genauer anschauen. Dabei ist die mindUp Web + Intelligence GmbH für den Bereich des Findens der gehackten Websites zuständig, die BDO Wirtschaftsprüfungsgesellschaft AG beschäftigt sich mit der forensischen Analyse der gehackten Websites. Wir von der Forschungsgruppe Security – Usability – Society (SECUSO) am Karlsruher Institut für Technologie (KIT) befassen uns mit der Benachrichtigung der betroffenen Website-Besitzer:innen.

Wie funktioniert INSPECTION? Und wie unterscheidet sich INSPECTION von anderen Sicherheitssystemen?

INSPECTION per se ist kein „Sicherheitssystem“. Wie oben schon beschrieben, geht es uns in dem Projekt darum, eine bestimmte Form von Angriffen auf Websites genauer zu beschreiben. Das Schwierige hier ist, dass diese Form des Website-Hackings a) noch sehr wenig bekannt ist und daher die wenigsten Website-Besitzer:innen wissen, wie man diesem Angriff begegnet, und b) die Angreifer:innen sich sehr gut im System verstecken und damit das Hacking lange Zeit unentdeckt bleiben kann. Es ist nicht selten, dass Websites über mehrere Jahre gehackt sind.

Unser Ansatz ist daher ganzheitlicher zu verstehen: Zunächst geht es uns darum, gehackte Websites zu identifizieren (Bereich „Finden“). Dieser Mechanismus wurde in den vergangenen drei Jahren von der mindUp Web + Intelligence GmbH immer weiter verfeinert, sodass in den kommenden Monaten ein Tool zur Einzelfallprüfung auf unserer Projektwebsite (web-inspection.de) zur Verfügung stehen wird, mit dem Website-Besitzer:innen selbst testen können, ob sie betroffen sind. Dieses Tool untersucht natürlich nur die von uns untersuchte Art des Website-Hackings und ist keine Garantie, dass die Website an sich frei von Malware ist. Aber das Tool ist eine sehr gute Ergänzung zu bestehenden Malware-Scannern, die wiederum nicht in der Lage sind, die von uns untersuchte Art des Website Hackings zu erkennen.

Weiterhin ist es uns wichtig, diese Art des Website-Hackings genau zu analysieren, Gemeinsamkeiten zwischen den betroffenen Systemen herzustellen und somit konkrete Lösungsvorschläge für Betroffene bereitzustellen (Bereich „Behandeln“). Die BDO Wirtschaftsprüfungsgesellschaft AG ist aktuell noch dabei, diese Analysen durch mehr Daten zu komplementieren. Die Analyse erfolgt über Logfiles kompromittierter Systeme. Hier sind wir stark auf die Zusammenarbeit mit den Betroffenen angewiesen und können Logfiles zum Beispiel nur sinnvoll auswerten, wenn uns diese auch zur Verfügung gestellt werden.

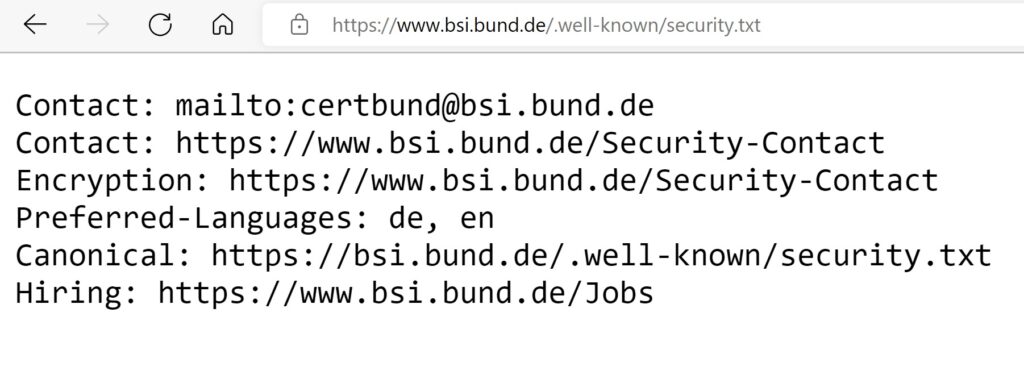

Hier spielt auch die Benachrichtigung von Betroffenen und damit die Entwicklung eines effektiven Benachrichtigungsverfahrens eine große Rolle. Wie bereits erwähnt, bleibt diese Art des Hackings oft lange unentdeckt. Wir von der Forschungsgruppe SECUSO am KIT erforschen, über welche Kommunikationswege und mit welchen Informationen wir am besten an Betroffene herantreten müssen, damit das Problem wahrgenommen und verstanden wird und daraus entsprechende Handlungen abgeleitet werden können. Dies ist nicht ganz so trivial, wie es klingt, da solche Benachrichtigungen oftmals im täglichen Spam untergehen und unsere Informationen die Betroffenen damit gar nicht erreichen.

Diese beiden Bereiche stellen die Basis für den Bereich „Verhindern“. Gerade sind wir noch dabei, Awareness-Materialien zu entwickeln, um Website-Besitzer:innen schon im Vorfeld auf die mögliche Gefahr aufmerksam zu machen. Der Fokus liegt dabei aktuell auf zwei Awareness-Videos, die ebenfalls zum Projektende zur Verfügung gestellt werden, sowie dem Tool zur Einzelfallprüfung.

Wie können die Forschungsergebnisse von INSPECTION zukünftig weiter genutzt werden? Was erhoffen Sie sich für Erkenntnisse für zukünftige Projekte und Forschungsansätze?

Wie bereits beschrieben, sollen alle Erkenntnisse aus dem Projekt öffentlich verfügbar sein. Der Schwerpunkt wird dabei auf dem Tool zur Einzelfallprüfung sowie den beiden Awareness-Videos liegen. Alle Informationen sollen auch Dritten zur Verfügung gestellt werden, so sind wir zum Beispiel mit dem Bundesamt für Sicherheit in der Informationstechnik (BSI), Deutschland sicher im Netz, einigen IHKs, Handwerkskammern und Fachverbänden, der Verbraucherschutzzentrale NRW, der Allianz für Sicherheit in der Wirtschaft (ASW), der Polizeilichen Kriminalprävention der Länder und des Bundes und natürlich dem ECO Verband in Kontakt.

Neben diesem konkreten Output interessiert uns als Universität natürlich vor allem auch die Übertragbarkeit unserer Ergebnisse auf andere, ggf. ähnlich gelagerte Probleme. Also zum Beispiel die Frage, wie man denn mit sogenannten vulnerability notifications („Benachrichtigungen zu Sicherheitslücken“) nun effektiv aus dem „täglichen Spam“ herausstechen kann. Hier haben wir im Rahmen des INSPECTION Projekts einige wertvolle Hinweise gewinnen können, die wir uns auch über das Projektende hinaus genauer anschauen wollen.

Auch beschäftigt uns die Frage, wie zielgruppenspezifisch denn Awareness-Materialien sein müssen. Da unsere Zielgruppe als „Website-Besitzer:innen und Stakeholder rund um Websites“ sehr, sehr divers, das eigentliche Problem aber teilweise sehr individuell ist, mussten wir sehr genau darauf achten, dass wir in unseren Materialien ausreichend allgemein und gleichzeitig spezifisch genug sind. Ich denke, wir haben hier einen guten Mittelweg gefunden. Aber das generelle Problem ist ja, wie mit solchen knowledge gaps („Wissensklüften“) zwischen verschiedenen Personengruppen umgegangen werden kann – das ist ja auch über den Cybersecurity-Bereich hinaus ein spannender Forschungsbereich.

Der Vortrag von Frau Hennig im Rahmen der Internet Security Days liefert vertiefte Einblicke in das Projekt. Zeit und Ort: Brühl, Phantasia-Land, ISD 2023 am 21.9.2023 um 15:30 Uhr